L’ottimizzazione del modello è un passaggio fondamentale del processo di Deep Learning. Dopo aver addestrato il modello e valutato le sue prestazioni, se il modello non funziona bene nella fase di validazione, può essere necessario ottimizzarlo. Questo processo può includere la modifica dei parametri del modello, l’aggiunta di regolarizzatori per evitare l’overfitting e la scelta di un algoritmo di ottimizzazione adeguato.

Indice dei contenuti

Modifica dei parametri del modello

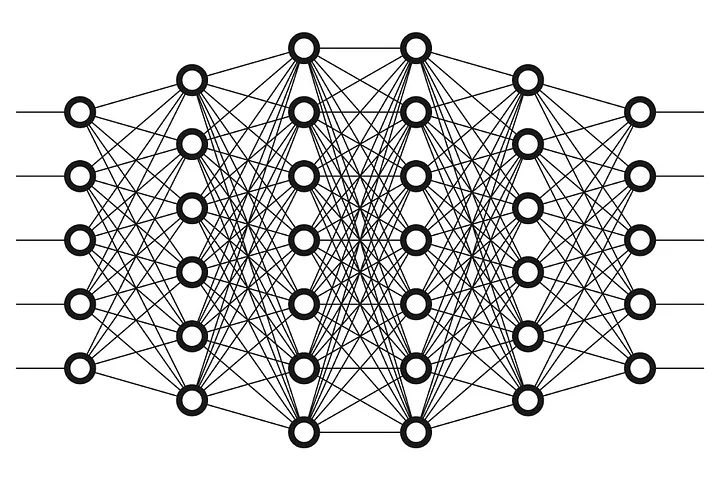

Una delle principali ragioni per cui un modello può non funzionare bene durante la fase di validazione è la scelta errata dei parametri del modello. I parametri possono includere il numero di strati, il numero di nodi in ogni strato, il tipo di funzione di attivazione utilizzata e il tipo di algoritmo di ottimizzazione. La modifica di questi parametri può aiutare a migliorare le prestazioni del modello.

Aggiunta di regolarizzatori

L’overfitting è un problema comune nella fase di addestramento del modello di Deep Learning, in cui il modello memorizza i dati di addestramento invece di identificare i pattern nei dati. Per evitare l’overfitting, può essere necessario aggiungere dei regolarizzatori come la regolarizzazione L1 o L2 o l’utilizzo della tecnica del dropout, che impedisce ai nodi del modello di adattarsi troppo ai dati di addestramento.

Scelta di un algoritmo di ottimizzazione adeguato

L’algoritmo di ottimizzazione utilizzato per addestrare il modello può influenzare le sue prestazioni. Alcuni algoritmi di ottimizzazione come Adam e RMSProp sono utilizzati comunemente nel Deep Learning, ma a seconda del tipo di problema e dei dati, può essere necessario scegliere un algoritmo diverso per ottenere le migliori prestazioni.

Valutazione dell’efficacia dell’ottimizzazione

Dopo aver ottimizzato il modello, è importante valutarne l’efficacia. Ciò può essere fatto attraverso la ripetizione della fase di validazione utilizzando il modello ottimizzato e confrontando le prestazioni con quelle del modello originale. Inoltre, l’utilizzo di tecniche come la cross-validazione può aiutare a garantire che il modello sia in grado di generalizzare bene su nuovi dati.

Considerazioni finali

In conclusione, l’ottimizzazione del modello è un passaggio cruciale per ottenere i migliori risultati possibili nel Deep Learning. La modifica dei parametri del modello, l’aggiunta di regolarizzatori e la scelta di un algoritmo di ottimizzazione adeguato possono aiutare a migliorare le prestazioni del modello. È importante valutare l’efficacia dell’ottimizzazione attraverso la ripetizione della fase di validazione e l’utilizzo di tecniche come la cross-validazione per garantire che il modello sia in grado di generalizzare bene su nuovi dati.